top of page

Solution Overview

ソリューション概要

ユーザーの質問に対してLLMが適切な回答を生成して応答するシステムです。

自社の各種マニュアルやドキュメント、データベースを取り込み、自社サーバにクローズドな形でLlama3を構築します。

自社業務アプリケーションや自社チャットにLLM(AI)を組み込みます。

組み込みは「チャット機能」と「API提供」の2つの方式を用意しました。

総務・人事系のシステムは、法令や労務管理をしっかり守る観点からシステムの使い勝手や効率が良いとは言えません。

利用者も通常業務が優先となり、つい労務管理は後回しになりがちです。各社、労務管理ルールは意外と複雑で

且つ、ケース毎に対応が異なる場合があり、それなりの専門性が求められます。

労務管理BoTがチャット上でアシスタントしてくれて、とても助かります。

ブラウザアプリでPCでも使えます。

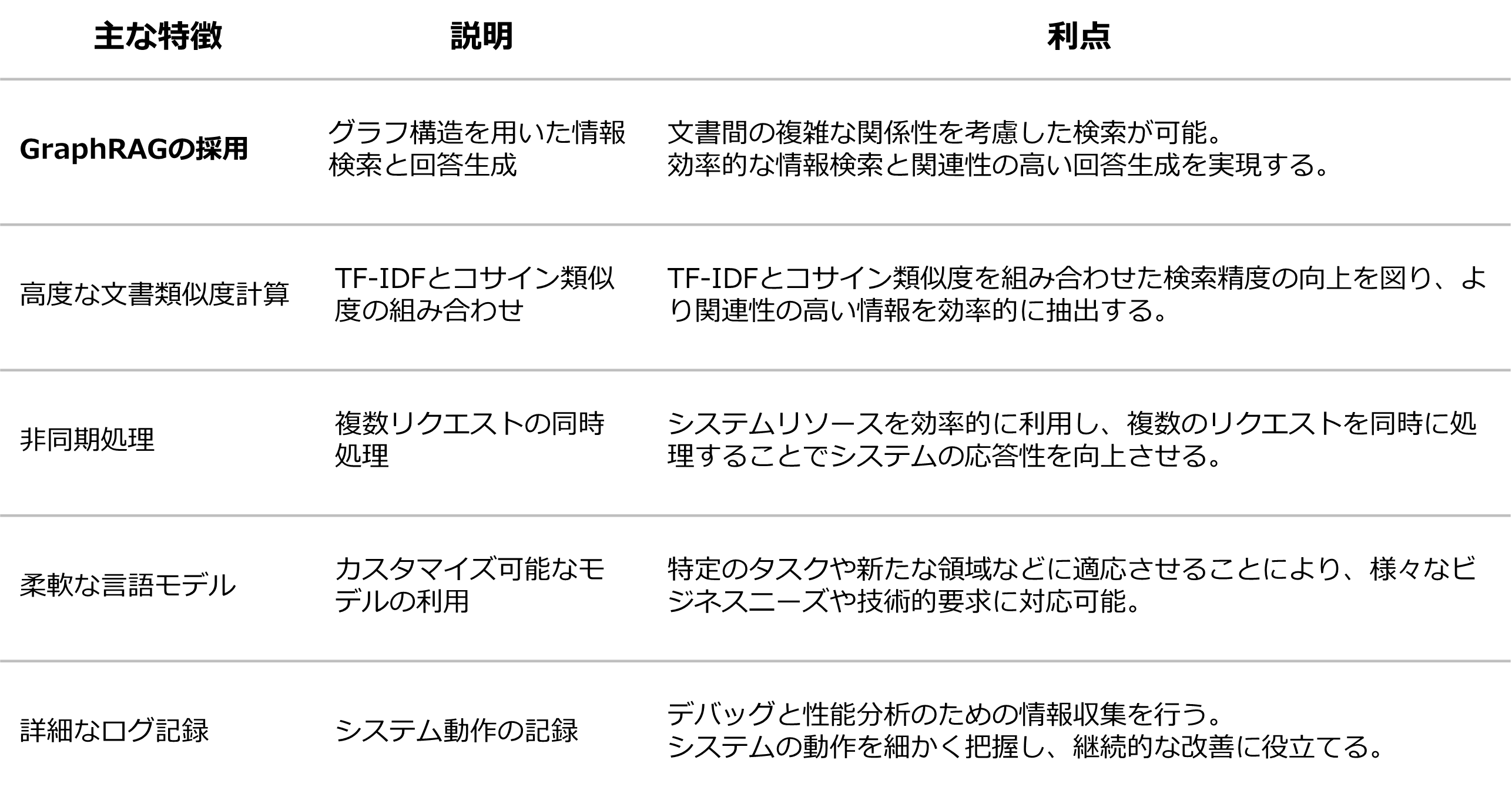

自社LLM構築設計ポイント

自社業務の高度な質問への回答能力と使い勝手の良いシステム実現を目指しました。

継続的な業務フィードバックと拡張性を備えます。

RAGとは

RAG (Retrieval-Augumented Generation):

LLM単体で回答生成を行うと「ハルシネーション(幻覚)や事前学習データにはない情報には正しく答えられない!」

といった問題がありました。RAGはこのような問題に対処する手法のひとつです。

LLMの事前学習データに含まれない知識(各社特有の情報など)を事前に知識ベースやドキュメントとして構築し

LLMに参照させることで、LLMはこうした新しい情報について正しく回答することが出来るようになります。

RAGは、特に知識集約的なタスクにおいて応答生成の精度と信頼性を向上させ継続的な知識の更新とドメイン固有の情報統合を

可能にすることが出来ます。

GraphRAG(Graph Retrieval-Augmented Generation):

従来のRAG(Retrieval-Augmented Generation)を拡張した手法でグラフデータベースを利用し

情報をグラフ構造(ナレッジグラフ)で表現することで、エンティティ間の関係性を考慮した検索と推論を行います。

Naive RAGやAdvanced RAGなどのRAG手法がベクトル化データの類似度に基づいて関連文書を検索するなど

主に数値表現の比較検索に依存するのに対しGraphRAGは情報の構造化と関係性の表現に優れており

エンティティ間の関係性を明示的に扱うことができます。

これにより、より複雑な推論や文脈理解が可能になり、質問に対する回答の精度が向上します。

bottom of page